Trender | 7 spådommer for data og analyse i 2023

06.02.2023 | 14 min lesetidKategori: Datamarkedet | Emneknagger: #arkitektur, #data lakehouse, #dataops, #governance

Har du full oversikt over alt som skal til for å bli mer datadrevet? Her er 7 utviklingstrekk du bør kjenne til innen kategoriene arkitektur, utviklerteam, dataflyt, DataOps/MLOps og governance, data science og analyse, leveransemodell og verdiskapning fra data.

Du finner en PDF-versjon her.

1. Arkitektur

Data lakehousene overtar!

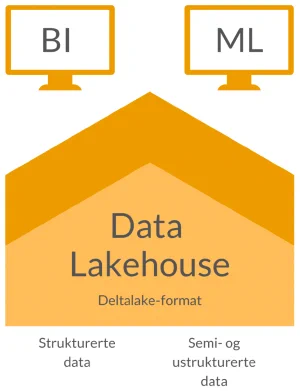

Data lakes (aka Hadoop-teknologi, aka Big Data) var mye snakket om en periode. Data lakes gir mulighet til å lagre svært store mengder data rimelig, og kan gi stor fleksibilitet til utviklere og data scientists til å lage avanserte dataprodukter. Med Spark fikk vi også muligheter for å skalere prosesseringen av store datamengder. Men - dataene må bearbeides videre for å gi verdi, og brukergruppen forble liten fordi datauttrekk og -prosessering krevde betydelig teknisk kompetanse.

Datavarehus har vi hatt i mange år. Den store fordelen med datavarehus at dataene er tilrettelagt for bruk gjennom felles datamodeller. En stor del av arbeidsmengden med å sammenstille og vaske data samt å standardisere forretningsmessige begreper, blir gjort på forhånd, slik at det for brukere blir en langt kortere vei til selvbetjening. På den andre siden krever det lang tid å bli enige og utvikle dette, og fleksibiliteten til å raskt lage noe nytt oppleves som begrenset.

Enkelte virksomheter har til og med både flere data laker og flere datavarehus. Data lakehouse-modellen, der vi har en data lake med rådata og logiske datavarehus-lag på toppen, bidrar til å minimere dataflytting. Delta Lake-filformatet (og alternativene Hudi og Iceberg) gjør at vi også får logiske databaseoperasjoner til Data lake-filer (ACID, at vi blant annet kan både endre og slette data - og det må vi kunne for å f.eks imøtekomme GDPR-krav). Teknologi som Databricks og Snowflake, kjørt på skyinfrastruktur, gjør det mye enklere å få dette til å spinne rundt. Endelig kan vi bruke energien vår på å skape verdi fra dataene, fremfor å jobbe med å provisjonere hardware, konfigurere for ytelse eller utføre oppgraderinger.

HVA SKJER I 2023?

Data lakehouse-arkitektur blir standarden for alle større virksomheter

Data lakehouses implementeres nå - overalt.

Hva dette betyr for deg kan følge to hovedspor

- Har dere ikke noe fra før? Om dere har tydelige use case dere ønsker å realisere som omfatter både rapportering og data science er nok data lakehouse-arkitektur verdt en diskusjon

- Mye teknisk gjeld og begrenset dokumentasjon? Det tar tid å flytte det gamle og man arver ofte veldig mye av den tekniske gjelden uansett. Vi anbefaler å vurdere hvilke deler av løsningen som bør bygges på nytt, og å gjøre dette med en gradvis tilnærming.

2. Utviklerteam

Flere innser at dataplattformen trenger et eget team

Så og si ingen etablerer nye dataplattformer på egen infrastruktur. De 10 prosentene som ikke velger Google Cloud, AWS eller Azure har enten store datasentre selv, for mye data som må prosesseres eller strenge regulatoriske begrensninger som gjør at skyløsningene ikke kan benyttes. Vi andre bruker skyen først.

Du trodde verden var enklere i skyen? Det er den, men plattformen i skyen skal gjerne løse flere typer use case utover den historiske rapporteringen. Nye roller for dataplattformen vokser frem. Et data lakehouse i skyen hverken etablerer seg selv, drifter seg selv eller får nye kapabiliteter av seg selv. I motsetning til mange andre hyllevare-applikasjoner så ligger mesteparten av innsatsen i hvordan dataene i plattformen innhentes, lagres og behandles.

Vi trenger dedikerte plattformarkitekter og -utviklere. Merk at dette ikke er data engineers med et nytt navn - dette er en helt egen rolle. Det skader imidlertid ikke at flere i dataplattform-teamet har bakgrunn fra ELT-utvikling.

HVA SKJER I 2023?

Flere bygger dataplattformteam

- Stadig flere selskap skjønner at utvikling av dataplattform ikke er det samme som å utvikle data-pipelines, rapporter og andre tjenester på en skyplattform eller i egen infrastruktur.

- Plattformteamet må ha god forståelse for forretningskrav som må oversettes til felles kapabiliteter, DevOps/DataOps/MLOps, infrastruktur, integrasjonsmetoder og -grensesnitt, dataflyt (ELT, Pub/Sub), modellering, overvåkning og datatesting (data observability) og ikke minst sikkerhet og tilgangsstyring.

- Super-personen som kan alt dette til fingerspissene finnes naturlig nok ikke, så bygg komplementær kompetanse i teamet. Bruk gjerne også konsulentmarkedet for å få etablert teamet, plattformen og gode prosesser og rutiner. Men - husk å bygge den interne kompetanse på veien!

Datakompetanse sprer seg som følge av nedgangstider

- Mindre funding til start-ups og scale-ups, og kostnadsreduksjoner i større virksomheter gjør at mobiliteten til datafolket øker. Selskap som Oda, Elkjøp, Google og Facebook kutter i arbeidsstyrken.

- Datafolket er fortsatt populære, og altfor få. Konsekvensen er at kompetansen spres, ikke minst innen effektiv organisering av dataplattform-team og deres samhandling med resten av organisasjonen.

3. Dataflyt

Flere muligheter på data-inntak og kode-først

Selv om ETL (Extract, Transform, Load) har levd godt de siste årtiene, har ELT (du gjettet riktig: Extract, Load, Transform) nå tatt over. Det gir mer mening å henter inn dataene først, og prosessere etterpå slik at vi kan dekke flere use case.

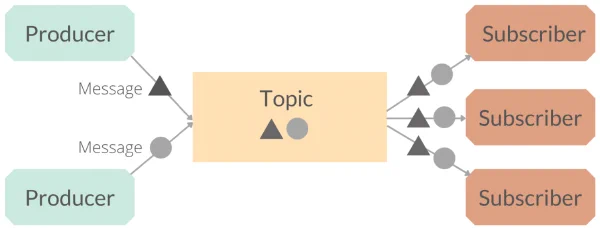

Datainnhenting (Extract) kan skje på flere måter. Alt må ikke gå gjennom et batch-basert integrasjonsverktøy (f.eks Informatica PowerCenter), men kan hentes inn via andre metoder. Noen ganger trenger vi data raskt. Pub/sub-integrasjon kan være arbeidskrevende, men frigjør dataene til all mulig bruk i nær-sanntid, også i miljøer utenfor dataplattformen. Datastrømmen blir egentlig mikrotjenester av dataprodukter, som ulike løsninger kan abonnere på. Kafka er fortsatt den ledende teknologiplattformen, men i Norge er det fortsatt relativt få som har mye erfaring med denne teknologien. Kompetansen som utvikles nå vokser frem fra generelle utviklermiljø, og ikke fra den tradisjonelle ETL-tunge datavarehus-verdenen.

Reverse ELT er et ganske ferskt begrep, og omhandler et subsett av dataintegrasjon knyttet til Master Data Management. Kort oppsummert: det finnes nå verktøy som dytter endringer i f.eks produktattributter inn i løsninger som trenger disse. Kanskje hører vi mer om dette i løpet av årene fremover, eller det blir bare en naturlig kapabilitet innen de etablerte MDM- og dataintegrasjonsverktøyene.

Innen datatransformasjon finnes mange visuelle verktøy (som Alteryx, Matillion eller Mapping Data Flows i ADF) som gjør at så å si alle kan transformere data uten å kunne skrive en linje med kode. Det er jo flott, for dette støtter data-demokratisering? Men - for mer avansert transformasjonslogikk ender de fleste med å legge inn custom code som en del av den visuelle flyten. Og da blir det plutselig ikke så oversiktlig.

Samtidig er det vesentlig enklere å kunne bruke SQL (eller Python) for å skrive transformasjoner, og helst i verktøy som dbt, Dataform eller Delta Live Tables der kode kan gjenbrukes og man har full støtte for CI/CD. Dette gir i tillegg muligheter for å bygge inn data observability og mye annet.

HVA SKJER I 2023?

Ja takk, vi vil ha flere måter å få tak i data på

En trend som for meg er blitt tydelig er at vi sier som regel “ja takk” til flere måter å få data inn til en dataplattform på. Vi har noen arkitekturmønstre som vi foretrekker (fordi det er billigst/enklest/best å overvåke etc), og noen vi bruker av og til. En kombinasjon av ELT og Pub/sub er nok en lite kontroversiell spådom.

Det betyr minst tre ting:

- Data engineers må enten lære seg flere verktøy og arkitekturmønstre, eller samarbeide med ulike utviklerteam for å få dataene inn.

- Integrasjonsarkitektene må beherske data-arkitektur i større grad.

- Det blir viktig å forstå hvor dataene kommer fra, hvordan de er behandlet og hvilke forutsetninger man kan legge til grunn når dataene skal tolkes. Dette betyr at verktøyer og kapabiliteter som datakatalog og data lineage blir viktigere.

GUI vs kode for transformasjon: foreløpig uavgjort, men vi heier på kode!

Hva skal vi velge? Det kommer an på er som vanlig svaret:

- Mindre organisasjoner der use casene er enkle kan gjerne bruke verktøy som Data Factory og Alteryx - som representerer Low code/no code.

- Større organisasjoner som har “proffe” utviklermiljøer bør i størst mulig grad benytte kode. I hvert fall for de offisielle dataflytene. Superbrukere i linja vil i stor grad også kunne bruke kodebaserte verktøy - og elske det. Dataflyt som er under testing og utforskning, eller som ikke er kritiske, kan utvikles i low-code/no-code-verktøy om ønskelig.

AI-basert datakvalitet og datatransformasjon øker farten til utviklere

Generativ AI vil effektivisere utvikling av transformasjonsjobber - og også benyttes innen dataprofilering og datavalidering. Nå som vi kan i klartekst si f.eks at “gi meg en tabell som viser omsetning summert per måned, fordelt på produkt” og så få et forslag til SQL-kode, vil det for mange gå betydelig fortere å utvikle transformasjoner. Dette vil bli bygget inn i de fleste verktøy der kode skrives.

Universelle semantiske lag lanseres, men blir de tatt i bruk?

Universelle semantiske lag ble lansert av dbt og Looker i 2022, og det blir spennende å se om konseptet brer om seg allerede nå. Formålet er å kunne tilgjengeliggjøre definerte måltall og KPIer på tvers av organisasjonen og sikre at alle bruker de samme definisjonene og det samme datagrunnlaget. Datasett og presentasjon skiller lag, er annen måte å se på dette. Det er vel et forsøk på å fravriste Power BI rollen som verktøyet som fikser alt?

4. DataOps, MLOps og Data Governance

Data observability + datakatalog?

Det finnes mange Ops-begreper. For et par år siden kom MLOps - dvs drift og videreutvikling av maskinlæringspipelines. Og nå snakker vi om DataOps. Ingen har vel helt landet definisjonen av begrepet, og de praktiske konsekvensene, utover at det handler om å få prinsipper knyttet til DevOps+Smidig fra programvareutvikling til å møte dataverdenen.

HVA SKJER I 2023?

Det er tre områder som peker seg ut som trender for 2023 innen DataOps og Data Governance:

Data observability blir noe data engineers begynner å prate om, men få virkelig får til å svinge

- Data observability handler om å automatisere overvåkning av dataflyten, med vekt på data lineage (hva som har skjedd med dataene frem til et punkt) og datakvalitet (ulike logiske sjekker som viser om dataene har endret karakter utover det vi forventer). Her modnes både verktøy og metoder over tid, men foreløpig er vi startgropen.

Mye data, mange brukere, og mange ulike use case krever en datakatalog

- Datakataloger krever mye av mennesker og prosesser for å enes om definisjoner, eierskap og rutiner. Den praktiske konsekvensen er at datakatalog-initiativ skaleres ned til de mest sentrale data-domenene og holdes på et minimum. Og det er greit. Og kanskje er det også slik at vi kommer til å ha datakatalog-kapabiliteter spredd på flere verktøy.

- Hva ønsker vi oss? Jo, automatisert generering og deling av metadata gjennom hele dataflyten, tilgjengelig for alle som trenger de, med muligheter for sosial samhandling slik at vi kan lære av hverandre hvordan dataene bør brukes.

Vi får mer oppmerksomhet rundt MLOps

- Vi ser fortsatt at implementering av løsninger som inneholder komponenter basert på AI (dvs maskinlæring, nevrale nett etc) har en del mangler. Dessverre kommer de fleste løsningene ikke forbi PoC-stadiet. Om de gjør det, er det altfor mange som ikke blir implementert skikkelig. Med det mener vi eksempelvis at kritiske løsninger kjøres i utviklingsmiljøet, og de ikke følger retningslinjene til arkitektur, sikkerhet etc i virksomheten. Og - modellene overvåkes bare sporadisk og har utydelige prosesser for feilhåndtering og videreutvikling.

- Det krever innsats for å skalere og integrere modellene til å kunne kjøre i produksjon, og vi må gå opp monitorering, vedlikehold og videreutvikling av dataflyt og modellflyt. Heldigvis er det økende oppmerksomhet rundt MLOps, og en del virksomheter som er proffe på det i dag. Denne kunnskapen er i ferd med å spres.

5. Data Science og analyse

Leve forretningsanalytikerne!

Vi er ute etter å løse forretningsproblemer og bruke data til å støtte operativ drift. Min påstand er at fleste virksomhetene heller ikke er klare for å ta i bruk de mest avanserte metodene. Så lenge de ikke har kontroll på grunnleggende prosesser knyttet til dataforvaltning og å bruke data til å svare på forretningsspørsmål som “hva har skjedd”/“hvorfor skjedde det”, så vil en oppskalering av virksomhetens kollektive datakompetanse ha relativt mye større verdi enn å optimalisere smale use caser.

HVA SKJER I 2023?

Forretningsanalytikere først

Data science som begrep roer seg ned litt, og forretningsanalytikerne inntar rampelyset. Forretningsanalytikerne kan vi som regel dyrke frem selv, mens produktive data scientists er svært vanskelig å hente inn.

Økt bevissthet rundt kompetanseheving? Ja takk!

Dyrking av den kollektive evnen til å bruke data er viktig, og for mange ligger det fortsatt stort potensiale for verdiskapning fra data her. Interne kompetanseprogrammer fortsetter å bli gjennomført for å øke kompetansen, men dessverre vil fortsatt de fleste være fokusert på hvordan bruke Excel/Power BI/Tableau og andre selvbetjeningsverktøy, fremfor å bruke data til problemløsing.

6. Leveransemodell

Desentralisert eierskap brer mer om seg

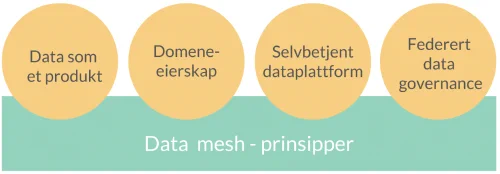

Jobber du innen data-verdenen har du sikkert fått med deg begrepet data mesh. Begrepet ble først beskrevet i to blogginnlegg skrevet av Zhamak Dehghani i 2019: “How to Move Beyond a Monolithic Data Lake to a Distributed Data Mesh” og “Data Mesh Principles and Logical Architecture”.

Kjerneideen er at virksomheter kan bli mer datadrevet ved å flytte fra sentrale datavarehus og data laker til domene-orientert dataeierskap og arkitektur, drevet av selvbetjent analyse og et sett felles retningslinjer. Svakheten med dagens organisering er at vi skaper flaskehalser i det sentrale leddet som en dataplattform er. Data Mesh søker å fri seg fra en sentralisert arkitektur ved å desentralisere både eierskap og ansvar for å utvikle dataprodukter.

Det som gjør det hele litt forvirrende, er at Data mesh ikke er noe som kan kjøpes. Det er mer et konsept for organisatorisk design, som består av biter som skal settes sammen som et puslespill.

HVA SKJER I 2023?

Desentralisert eierskap skyter fart, men tilpasses virkeligheten

Selskap som Zalando, ODA og Adevinta er nå aktive med å fortelle hvordan de implementerer Data mesh. “Ekte” data mesh har de færreste enda, siden de fleste organisasjoner må skalere opp analytisk og teknisk kompetanse betydelig for å kunne drive frem domene-basert eierskap og arkitektur. Og mange er i ferd med å innse at det blir krevende å skille ut eierskaps- og leveransemodeller kun for dataprodukter, når resten av det digitale økosystemet også bør ses på på samme måte.

Desentralisert eierskap til datasett, rapporter og analysemodeller brer mer om seg, men vi er ikke fanatiske. Det tar lengre tid med dataflyter og datadomener (tenk “Kunde” eller “Produkt” som domener). Og det er ikke sikkert alle bør desentralisere alt - data mesh som designkonsept passer ikke alle typer virksomheter - spesielt ikke de små og mellomstore.

Det kan også være verdt en debatt om man trenger å desentralisere arkitekturen (vi får til mye med teknologier som Snowflake, Databricks og dbt i en sentral plattform), det er vel egentlig gjennom organiseringen verdien av Data Mesh realiseres?

7. Fra data til verdi

Alle innser at de må bli datadrevet. Og AI til folket.

Blir norske virksomheter mer datadrevne? Kanskje. Det finnes nok flere som har gjort undersøkelser her. Modning krever tid, og kommer ikke tilfeldig. Heldigvis har vi fått svært synlige synlige internasjonale - og noen få norske - eksempler på at data er den store forskjellen på å være bransjeleder og den som ligger bakerst i feltet.

Vi trenger ikke lenger mye bruke tid på å argumentere for at data kan gi verdi. I stedet handler samtalene handler primært om å konkretisere hvor stor verdi, hvor vi har størst potensiale, og hva som må til for å komme dit. De fleste har gjort noe, og er i ferd med å gjøre mer.

HVA SKJER I 2023?

Kan vi begynne å snakke mer om fremtiden?

Vi prater mindre om avansert analyse, og mer om å bli datadrevet gjennom alle prosesser. Vi må rett og slett få faktabaserte beslutninger, kunne se mer fremover gjennom prediksjon og automatisere der vi har repetitive oppgaver som som følger standardmønstre. Og apropos prediksjon, jeg skulle gjerne ønsket at flere ledere spurte forretningsanalytikerne sine om vi kan forsøke å se på hva som kan skje fremover (neste uke, neste måned og neste år).

Prosessforbedringsarbeid blir mer datadrevet

Personlig har jeg et håp om at prosessforbedring, der Lean har vært moteordet i årtier, kan på sikt fusjonere med datadrevet automatisering og problemløsning. De store konsulenthusene har nå både Lean-konsulenter og datakonsulenter, men samordningen og samarbeidet har ikke vært imponerende så langt. 2023 må bli året der noen griper muligheten, og får de første norske suksesshistoriene som alle snakker om. Hansken er kastet, som de sa i gamle dager.

ChatGPT åpner øynene til alle for verdien til AI

ChatGPT har åpnet øynene til de fleste - og nå har over 100 millioner brukere testet hvordan såkalt generativ AI kan brukes til å automatisere oppgaver som tekstskriving og finne frem fakta. Mange flere skal det bli i løpet av året, når tjenester som Microsoft Teams begynner å bygge inn kapabilitetene inn i tjenestene sine. For eksempel får vi nå møtereferat med aksjonspunkter servert rett etter møtet. Skoleelever og studenter verden over ser muligheten til å effektivisere oppgaveskrivingen - til stor glede. Samtidig vil de samtidig oppdage at AI har bias, at tekst-algoritmer ikke kan regne og at fakta ikke alltid er fakta.