Dataplattform | Komponentene i en dataplattform

01.07.2024 | 22 min lesetidKategori: Dataplattform | Emneknagger: #dataplattform, #AI, #arkitektur

Lær om de sentrale komponentene som utgjør en moderne dataplattform, og forstå hvordan de virker sammen for å samle, lagre, prosessere og presentere data. Vi forklarer hvordan en dataplattform muliggjør ulike use case fra datakilder til konsum.

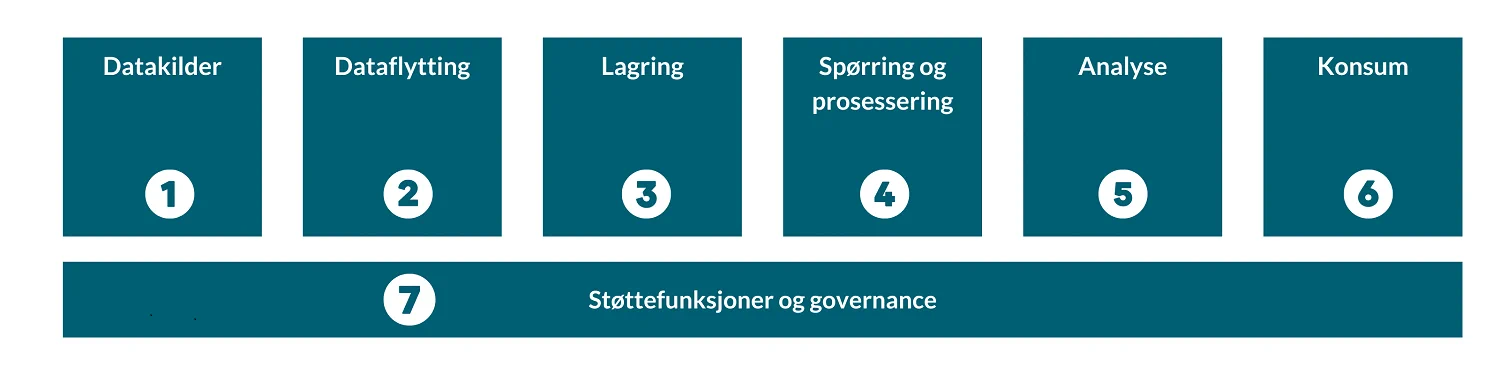

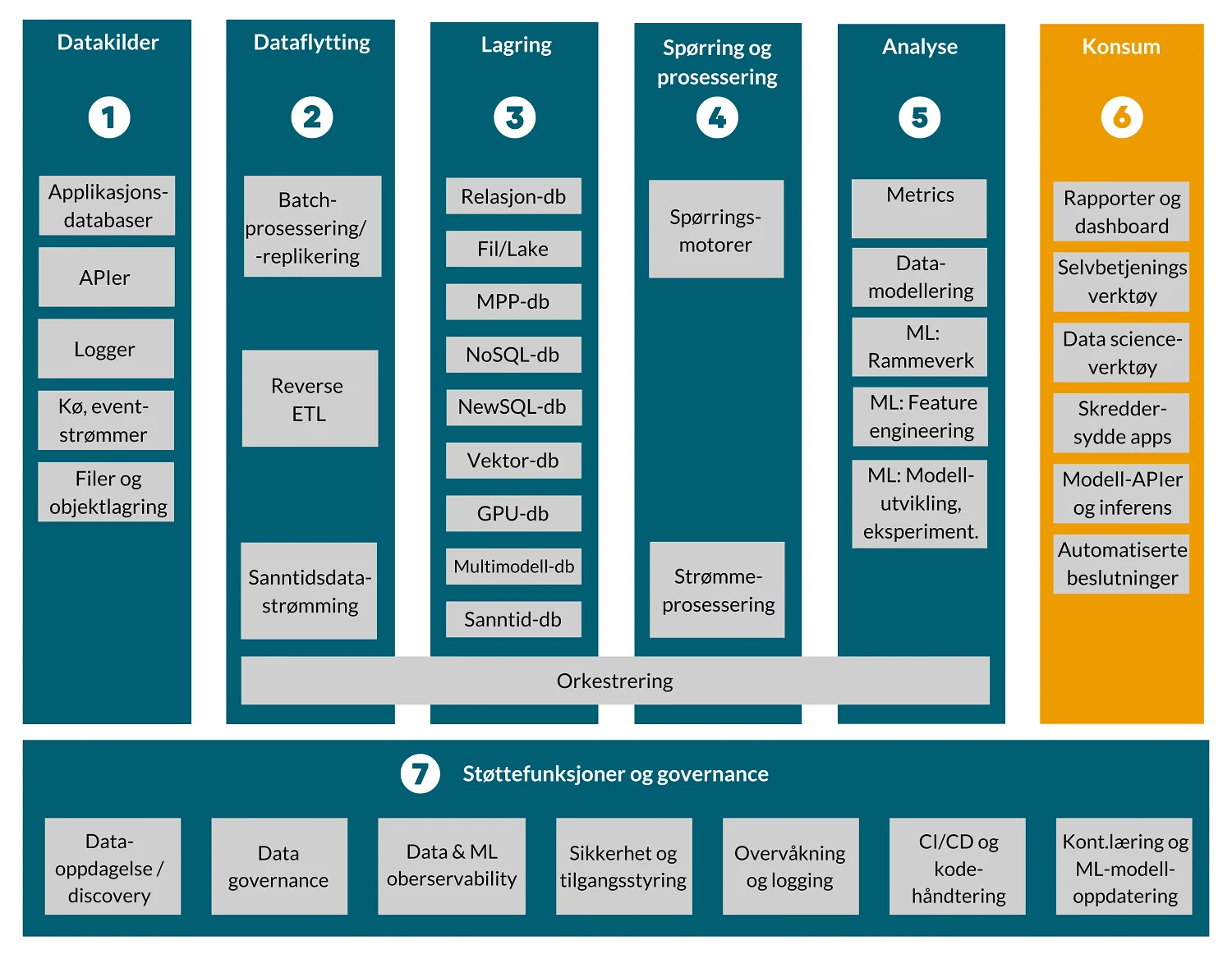

Helikopterperspektivet: komponentene i en dataplattform

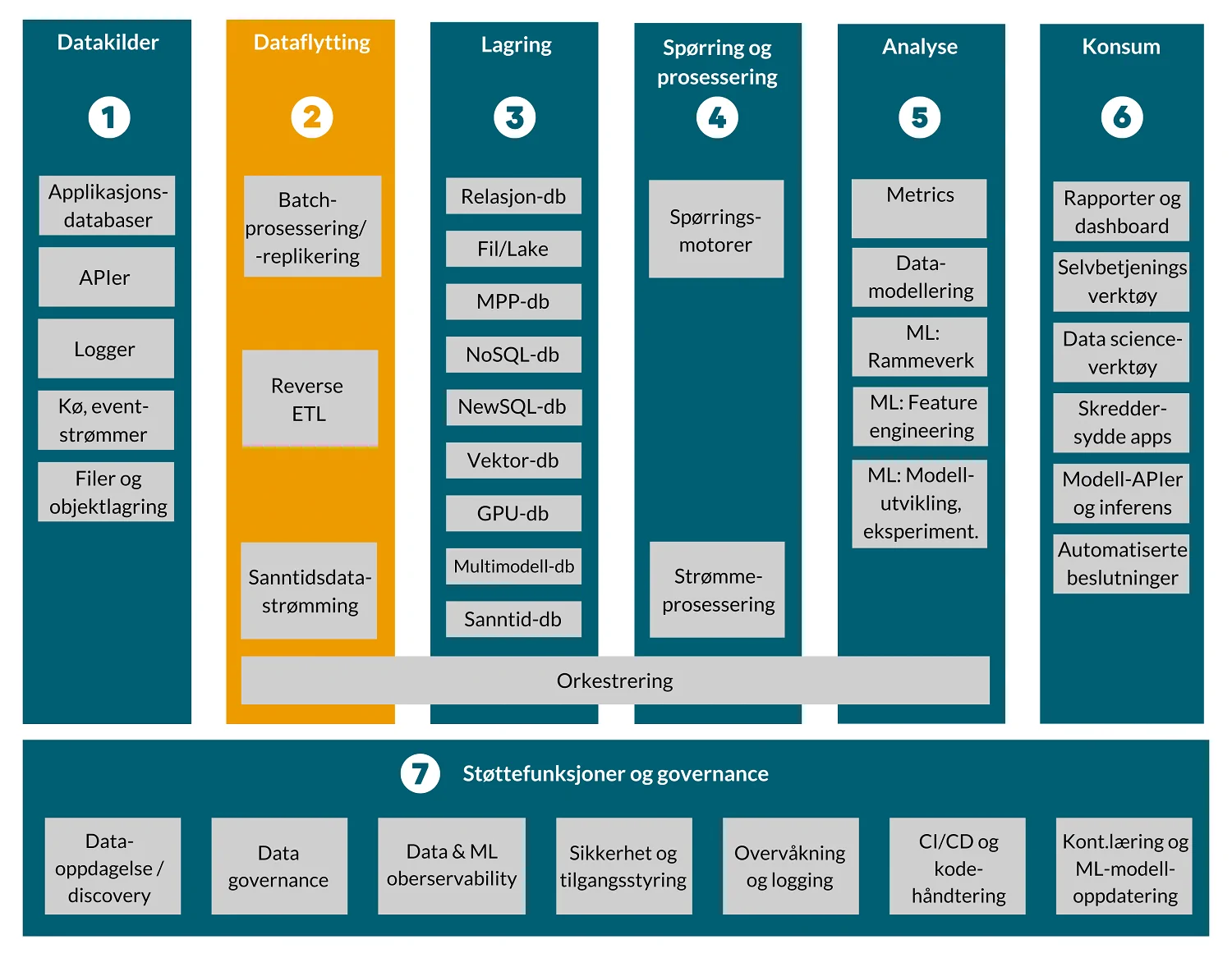

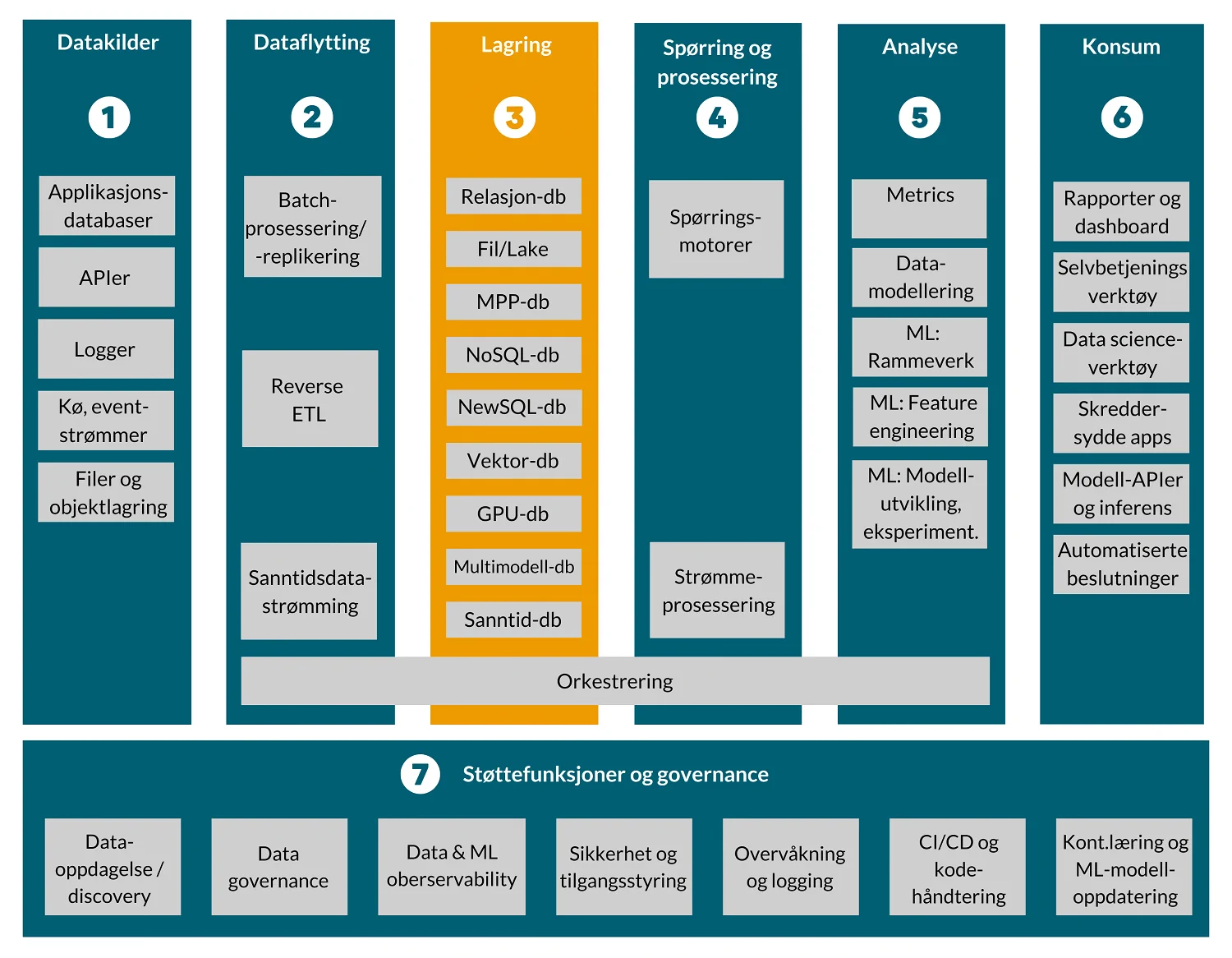

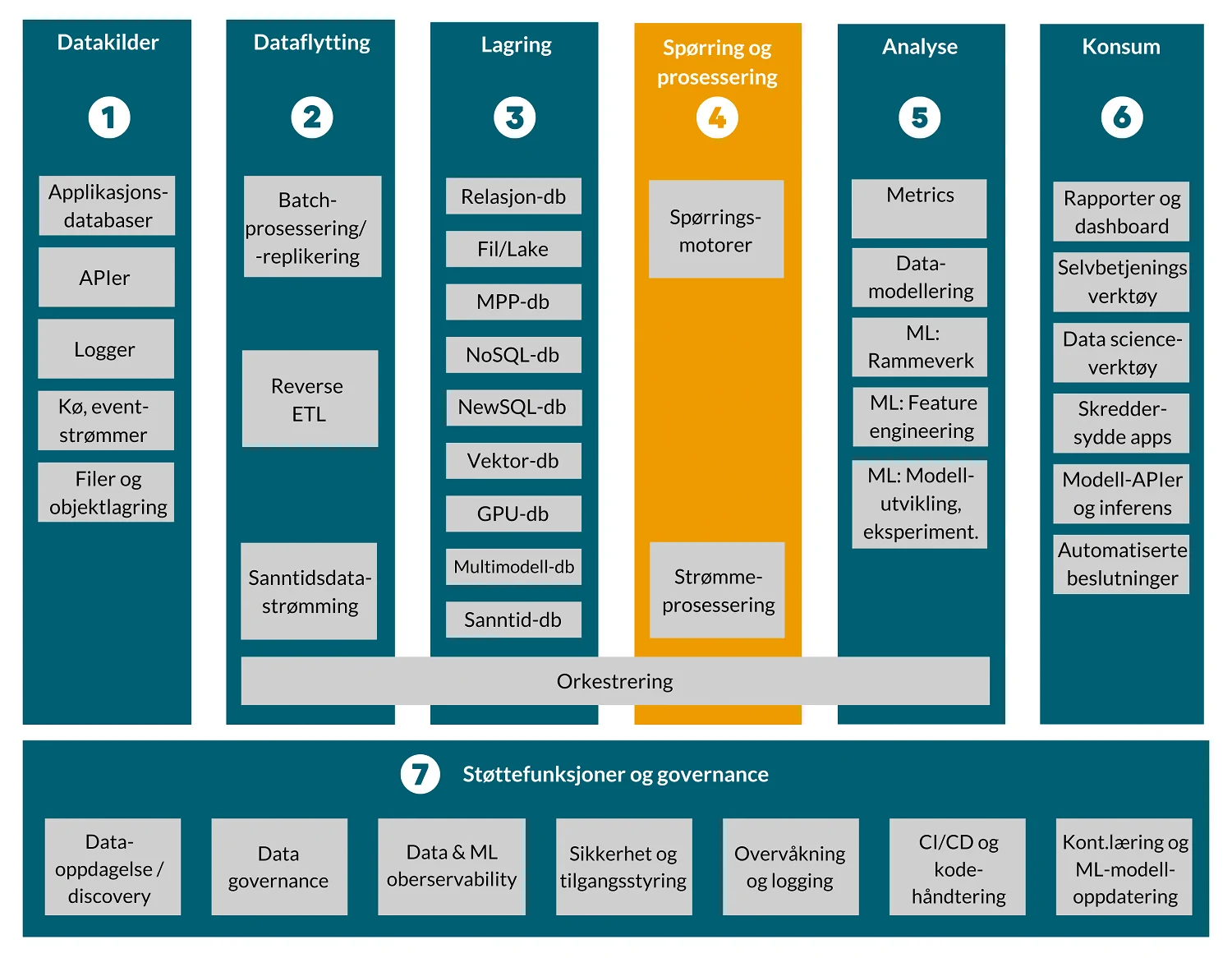

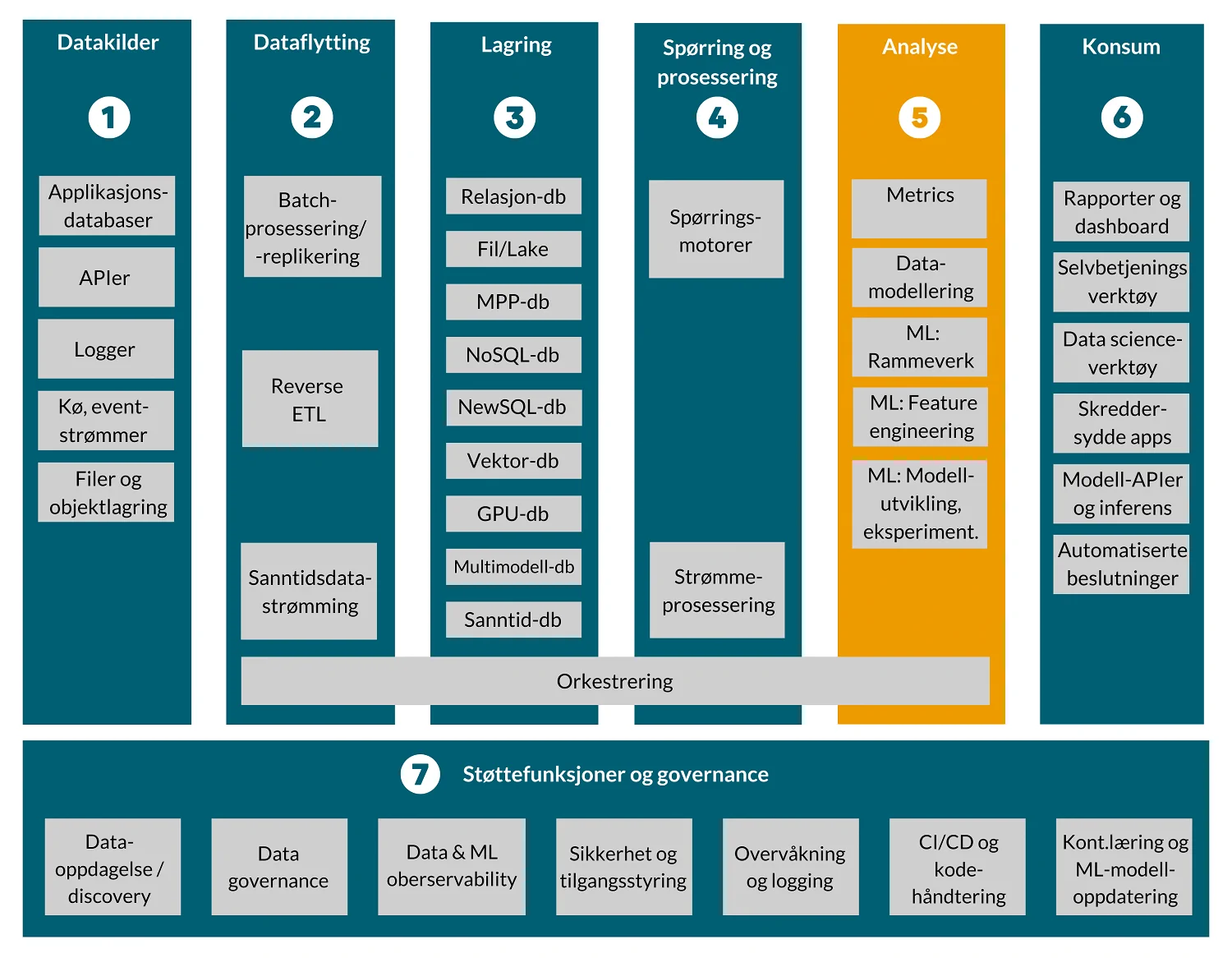

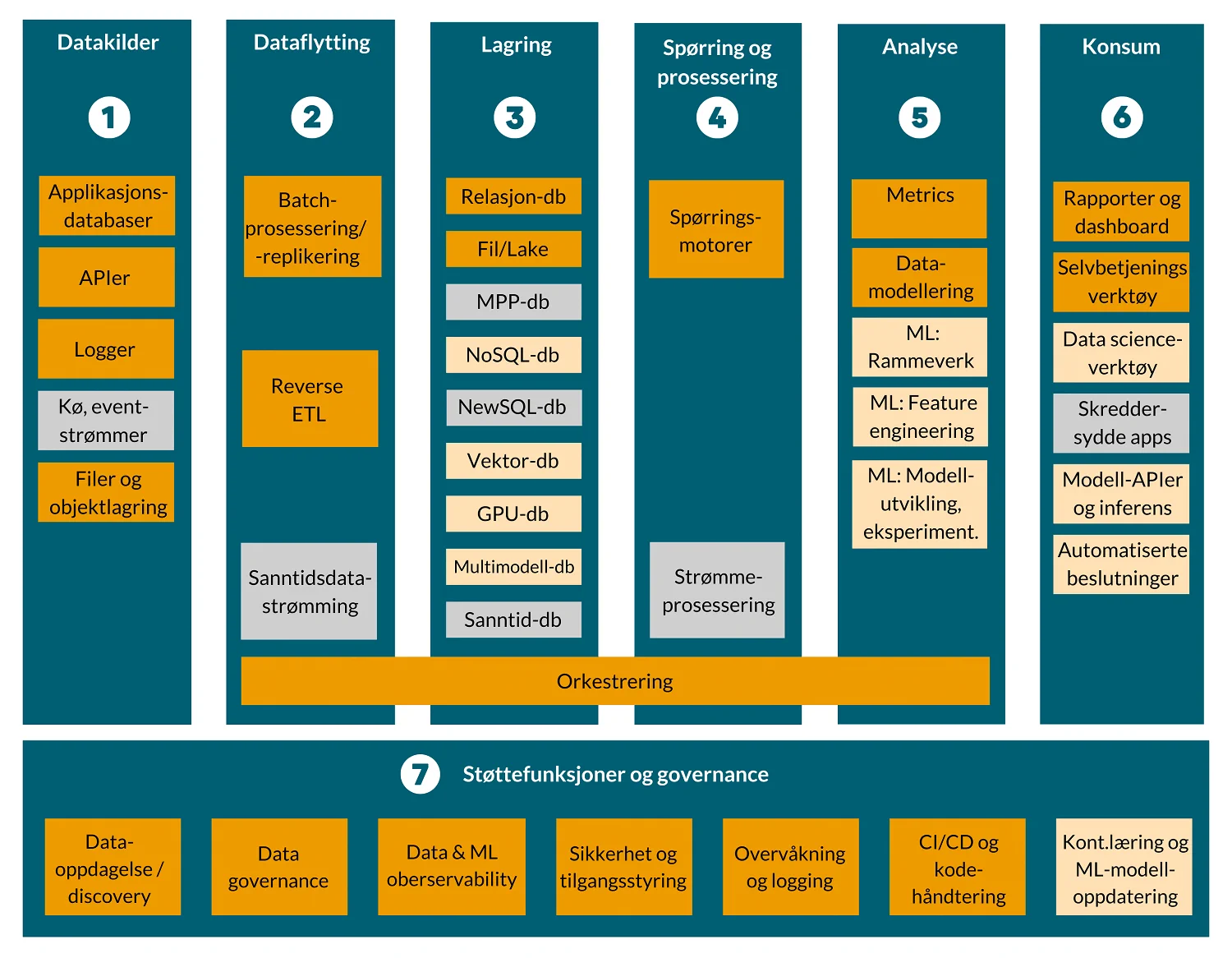

En dataplattform består grovt sett av syv ulike komponenter, som illustrert her.

- Datakilder: Leverer data om relevante hendelser, forretningsmessige transaksjoner, master data, referansedata, mv.

- Dataflytting: Ekstraherer data fra operasjonelle systemer og andre kilder til data. Leverer data til lagringstjenesten på et skjema som er kompatibelt med kilde og mål, med en bestemt frekvens, lastemetode og tidspunkt.

- Lagring: Lagrer data i et format som er egnet for spørringer og systemer som prosesserer. Optimaliserer for lav kostnad, skalerbarhet og analytiske arbeidsoppgaver (f.eks. kolonnebasert lagring)

- Spørring og prosessering: Tilbyr grensesnitt for data engineers, analytikere og data scientists for å eksekvere spørringer mot lagrede data og utnytter parallellisering (distributed compute) for hurtigere responstid. Gir mulighet for å beskrive hva som har skjedd og å predikere hva som vil skje. Støtter maskinlæring og AI-baserte løsninger.

- Analyse: Transformerte data foredlet til strukturer som er bedre egnet for spesifikke analyser.

- Konsum: Presenterer resultater av spørringer og dataanalyser til brukere eller som grensesnitt til andre applikasjoner.

- Støttefunksjoner og governance: Sørger for koordinering av dataflyt, eksekvering av spørringer og transformasjoner for hele dataflyten på tvers av lagene. Sikrer datakvalitet, ytelser og styring (governance) for alle systemer og datasett.

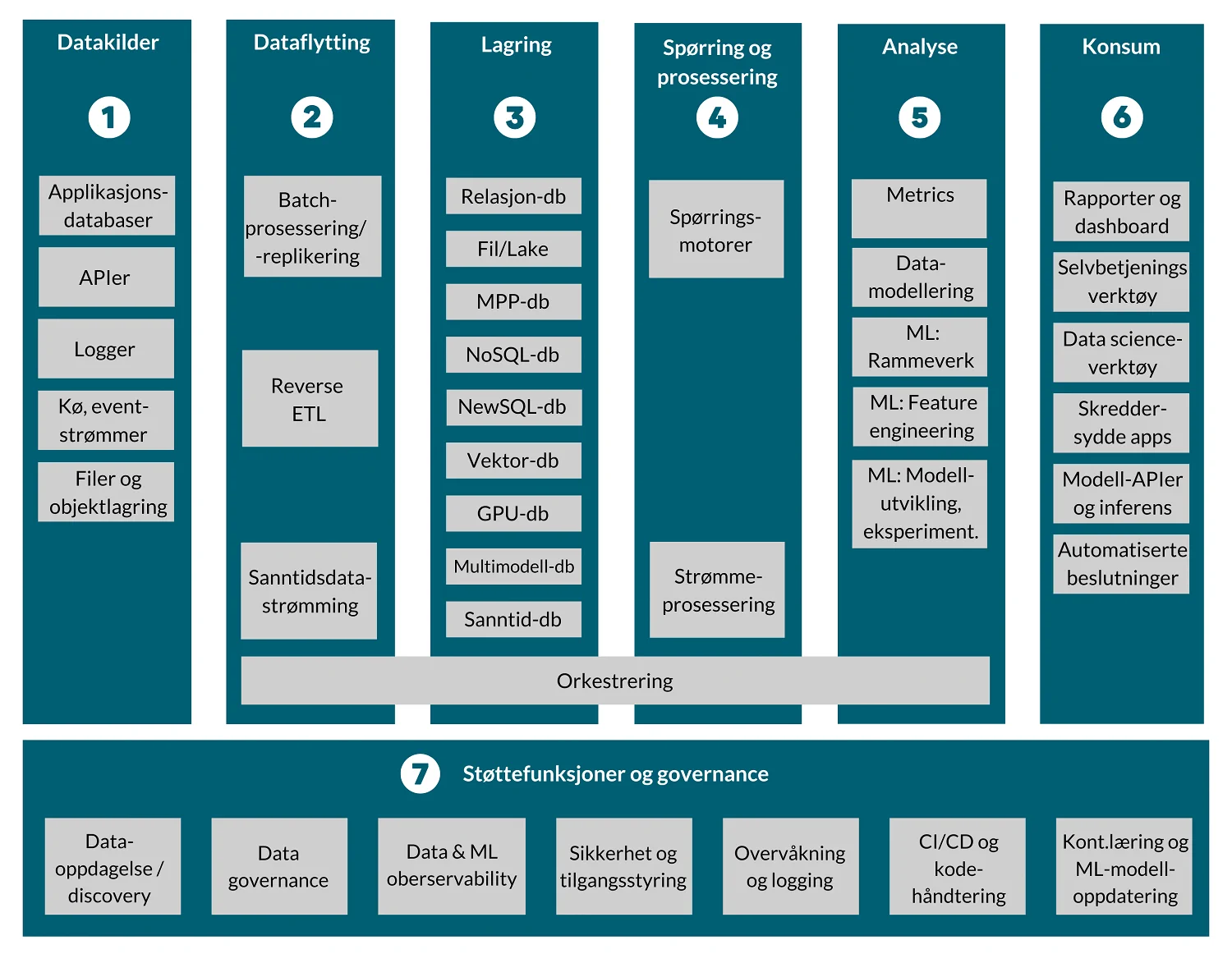

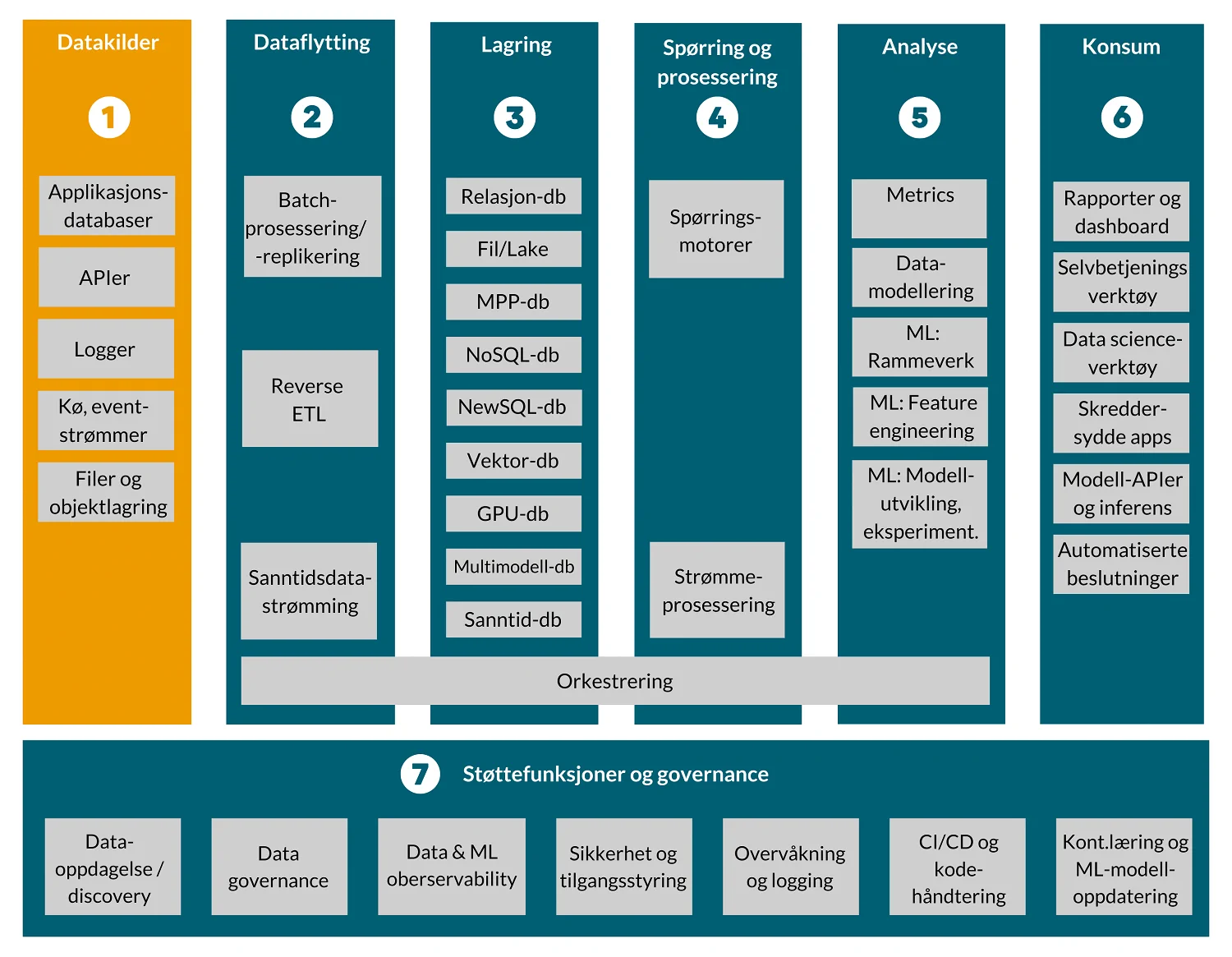

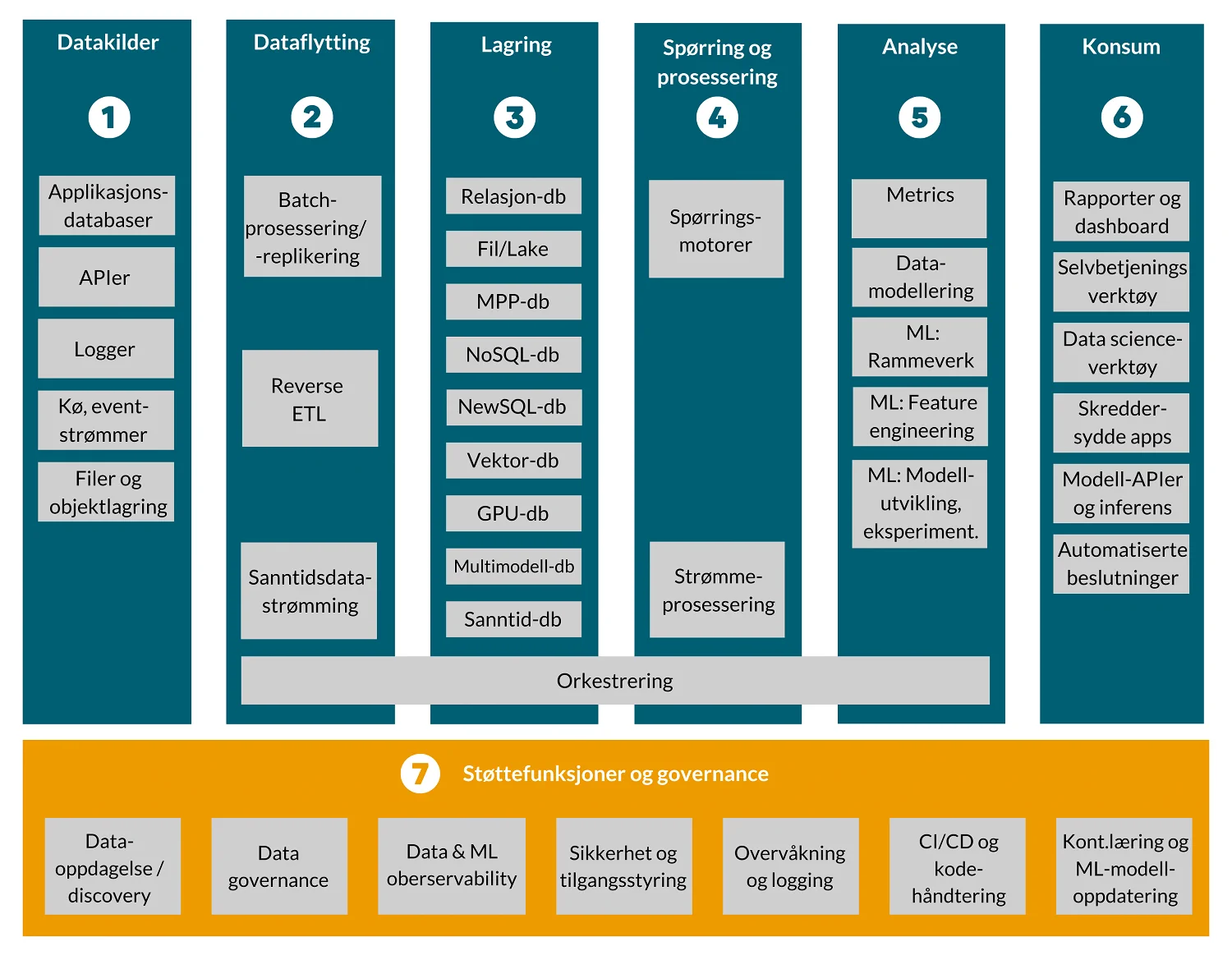

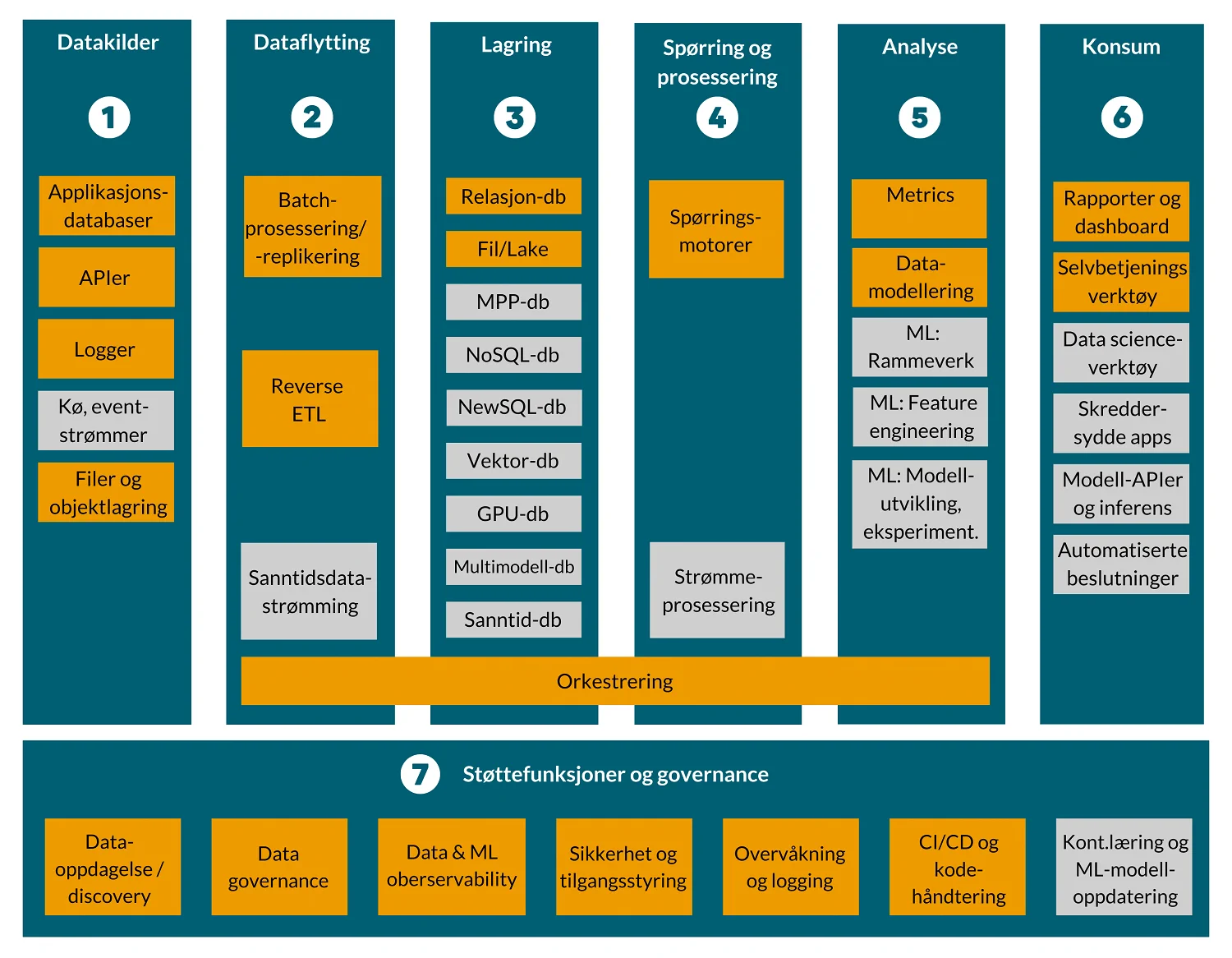

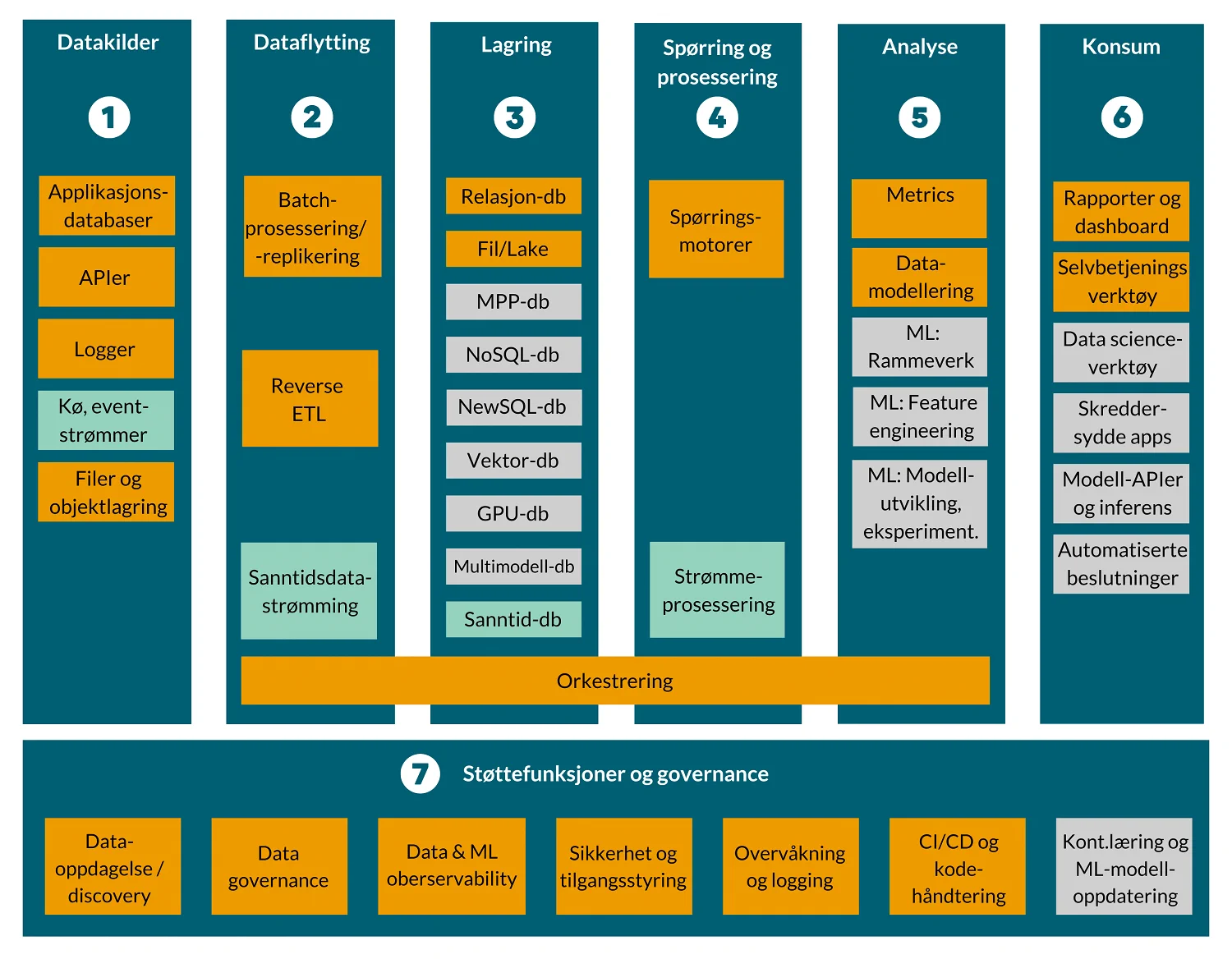

Om du ser enda mer detaljert på de ulike komponentene, kan det se omtrent slik ut:

1. Datakilder

Datakildene gir oss rådata. Data skapes i operasjonelle systemer som driver virksomheten, ofte som beskrivelser av transaksjoner. Data leveres i ulike formater, detaljnivåer og hyppigheter.

Moderne virksomheter med en datadrevet applikasjonsportefølje har systemer som genererer data hyppig, som for eksempel clickstream fra websider og apper, og eventlogger med kontinuerlige datastrømmer fra sensorer. Datakilder kan også være eksterne parter som leverer markedsdata, værdata og finansielle data.

Datakilder er sjelden bygget for å levere data ut, og måten de leverer data på, varierer. Vi bruker derfor begrepet disparate kilder eller disparate data for å beskrive utfordringen med å sammenstille data på tvers av kilder og forretningsområder.

De viktigste kategoriene datakilder er:

| Datatype | Beskrivelse |

|---|---|

| Applikasjons-databaser | Strukturerte datakilder som lagrer data generert av virksomhetens applikasjoner. Dette inkluderer relasjonsdatabaser som MySQL, PostgreSQL og SQL Server, hvor data er organisert i tabeller med rader og kolonner. Disse databasene inneholder ofte transaksjonsdata, kundeinformasjon, produktdata og annen viktig forretningsinformasjon. |

| APIer | Gir programmatisk tilgang til data og funksjoner i applikasjoner og tjenester. APIer kan hente data i sanntid, som finansielle data, værdata og sosiale medier-data. APIer er ofte RESTful eller SOAP-baserte og returnerer data i formater som JSON eller XML. |

| Logger | Tekstbaserte filer som registrerer hendelser i et system, inkludert serverlogger, applikasjonslogger og brukeratferdslogger. Logger er uvurderlige for feilsøking, sikkerhetsovervåkning og systemytelsesanalyse. |

| Køer/ event-strømmer | Brukes til å behandle og overføre sanntidsdata mellom systemer. De er nyttige for applikasjoner som krever sanntidsanalyse og responser, som IoT-enheter, finansielle transaksjoner og brukerinteraksjoner. |

| Filer og objekt-lagring | Omfatter ulike typer filformater som CSV, JSON, Parquet, og lagringssystemer som AWS S3, Google Cloud Storage og Azure Blob Storage. Disse lagrer data i en rekke formater og brukes ofte for batchprosessering og lagring av store datamengder. |

2. Dataflytting / dataintegrasjon

Dataflytting, også kalt “ingest”, er essensielt i en moderne dataplattform. Prosessen henter inn data fra ulike kilder og formater, standardiserer dem, og forbereder dem for videre prosessering og analyse.Målet med dataflytting er å gjøre datainntak så automatisert og sømløst som mulig, slik at data raskt kan transformeres og analyseres.

Hovedmetoder for dataflytting inkluderer:

- Batch-prosessering: Behandler store datamengder på bestemte tidspunkter. Nyttig for kilder som oppdateres periodisk og sikrer effektiv overføring og behandling.

- Sanntidsdatastrømming: Behandler data kontinuerlig etter hvert som de genereres, som sensordata. Viktig for applikasjoner som krever umiddelbare oppdateringer og raske responstider.

- Reverse ELT: Integrerer endringer i masterdata (f.eks. produktattributter) tilbake i systemer som trenger disse.

- Orkestrering: Koordinerer og effektiviserer gjennomføringen av ulike dataoperasjoner. Orkestreringsverktøy automatiserer workflows, håndterer avhengigheter og sørger for at dataflytting skjer i riktig rekkefølge og til riktig tid. Dette inkluderer bruk av Directed Acyclic Graphs (DAGs) som spenner fra rådata til transformerte data, inkludert maskinlæring.

3. Lagring

Lagringsteknologi benyttes både for å lagre data i råformat ved ingest og for lagring av data som er prosessert i ulik grad.

Lagringslaget i et dataplattform har som formål å tilby ulike typer teknologier for lagring som støtter krav til responstid, tilgjengelighet, oppetid, failover og katastrofehåndtering, med mer. For de aller fleste, vil lagringsteknologi i skyen være det mest aktuelle valget, fordi det tilbyr kostnadseffektiv og skalerbar kapasitet.

Avhengig av bruksformål så vil en dataplattform typisk inneholde følgende databaseteknologi innenfor lagringstjenestene:

| Lagringstype | Beskrivelse |

|---|---|

| Relasjons-databaser (RDBMS) | Relasjonsdatabaser er tradisjonelle databaser for strukturerte data fra transaksjonsorienterte kildesystemer som for eksempel ERP-systemer, banktransaksjoner og flyreservasjons-systemer. Disse brukes ofte til å lage datavarehus. |

| Fil-/Lake-lagring | Hadoop Distributed File System (HDFS) er en lagringsmetode som bruker et distribuert filsystem, og distribuerer filer blant en rekke maskiner med tilhørende lagring for å fremskynde lese- og skriveoperasjoner. Ofte omtalt som “Data Lake”, hvor store mengder rådata kan lagres kostnadseffektivt. |

| MPP-databaser | Massive Parallel Processing (MPP) databaser er en spesiell type relasjonsdatabase der data behandles på flere datamaskiner med tilknyttet lagring. Disse er laget for å håndtere forespørsler som krever enorme datavolumer og er ikke effektive for mange små forespørsler. |

| NoSQL-databaser | NoSQL-databaser bruker ikke tabeller for å organisere data som relasjonsdatabaser gjør. De ble introdusert for å løse noen av relasjonsdatabasens mangler når det gjelder skalering og fleksibilitet i datamodellen. Undertypene inkluderer dokumentorienterte databaser, key-value pairs, graf-databaser og kolonnebaserte databaser. |

| NewSQL-databaser | NewSQL-databaser kombinerer fordelene ved tradisjonelle relasjonsdatabaser med de skalerbare egenskapene til NoSQL-databaser. De er designet for å håndtere høye transaksjonsvolumer med ACID-egenskaper. |

| Vektor-databaser | Vektordatabaser lagrer data i form av vektorer, noe som er spesielt nyttig for maskinlæringsapplikasjoner som krever rask tilgang til høy-dimensional data. |

| GPU-databaser | GPU-databaser bruker grafikkprosessorer for å akselerere databeregningsoppgaver. De er ideelle for applikasjoner som krever høy ytelse og rask behandling av store datamengder. |

| Multimodell-databaser | Multimodell-databaser støtter flere datamodeller (f.eks. relasjonelle, graf, dokument) i én enkelt database, og gir dermed fleksibilitet til å håndtere ulike datatyper og arbeidsbelastninger. |

| Sanntids-databaser | Sanntidsdatabaser er optimalisert for å gi umiddelbare svar på forespørsler, og brukes i applikasjoner som krever rask tilgang til oppdatert informasjon. |

Her er viktige egenskaper du bør vurdere ved valg av lagringstjeneste:

- Responstid: Ulike lagringsteknologier er optimalisert for forskjellige responstidskrav. For eksempel gir in-memory databaser rask tilgang, mens HDFS er optimalisert for høy gjennomstrømming av store datamengder.

- Tilgjengelighet og oppetid: Lagringssystemene må være tilgjengelige og pålitelige for å sikre kontinuerlig tilgang til data. Dette inkluderer mekanismer for failover og katastrofehåndtering for å beskytte mot datatap og nedetid.

- Skalerbarhet: Lagringssystemene må kunne skalere for å håndtere økende datamengder uten å miste ytelse. Dette gjelder spesielt for systemer som HDFS og NoSQL-databaser som er designet for horisontal skalerbarhet.

- Kostnadseffektivitet: Valget av lagringsteknologi påvirker kostnadene for dataplattformen. Skybaserte lagringstjenester gir ofte en kostnadseffektiv løsning som kan tilpasses etter behov.

Valg av riktig lagringsteknologi er avgjørende for en effektiv dataplattform. Ved å kombinere forskjellige lagringsteknologier kan en dataplattform møte varierte krav til responstid, tilgjengelighet, skalerbarhet og kostnadseffektivitet.

4. Spørring og prosessering

Dataplattformen inneholder flere områder med ulike formål. Ved mottak er data lagret tilnærmet likt som i kilden, og blir deretter foredlet til modeller for generell analytisk bruk, eller modeller spesialisert mot bruk i et analytiske bruksscenarioer som maskinlæringsalgoritmer.

Prosesseringslaget har som hovedformål å koordinere og prosessere transformasjonene av data som lastes inn i dataplattformen, og som foredles til de datamodellene som dataplattformen inneholder som tilrettelegges i analyse- og konsumlagene.

Prosesseringsteknologi deles opp i prosessering av data per batch og prosessering av strømmende data, altså data som ankommer fortløpende og med svært hyppig frekvens:

- Batchprosesering med SQL- og Spark-baserte spørringsmotorer: Batch-prosessering innebærer å behandle store mengder data på bestemte tidspunkter. Dette er nyttig for oppgaver som ikke krever sanntidsresultater, som nattlige dataoppdateringer, månedlig rapportering og historisk dataanalyse. For de aller fleste analytiske behov er batchvis prosessering med frekvens på for eksempel 15 minutter, 60 minutter eller et døgn tilstrekkelig.

- Strømmeprosessering: For scenarier der det er behov for analytisk innsikt i nær sanntid vil være behov for prosessering av strømmende data med lav forsinkelse.

Viktige aspekter av ved bruk av spørringer og prosesseringskapabiliteter er:

- Parallelle og distribuerte beregninger: Ved å utnytte parallelle og distribuerte beregninger kan dataplattformen håndtere store datamengder og komplekse spørringer raskere. Dette innebærer bruk av flere prosesseringsenheter som arbeider samtidig for å fullføre oppgaver.

- Optimering av spørringer: Spørringsoptimering er prosessen med å forbedre effektiviteten av spørringer for å redusere behandlingstiden og ressursforbruket. Dette kan inkludere teknikker som indeksering, spørringsomskriving og bruk av materialiserte visninger.

- Datatransformasjon: Transformasjon innebærer å omforme rådata til et strukturert format som er egnet for analyse. Dette kan inkludere aggregering, filtrering, sortering og berikelse av data.

- Maskinlæring og AI: Dataplattformen støtter ofte avanserte analyser som maskinlæring og kunstig intelligens. Dette krever omfattende prosessering for å trene modeller, kjøre prediksjoner og evaluere resultater. Spesielt krever modellopplæring betydelig datakraft, spesielt for store datasett og komplekse modeller som dype nevrale nettverk. Skalerbar infrastruktur, som distribuerte databehandlingssystemer og GPU-klynger, er nødvendig for å håndtere disse kravene.

5. Analyse

Analyselagets formål er å tilby kvalitetssikrede analytiske tabeller for bruk i ulike former for verktøy i konsumentlaget. Dette laget er kritisk for å transformere rådata til innsiktsfulle, anvendelige data som kan drive forretningsbeslutninger. Analysen involverer datamodellering, metrics-lag, berikelse, aggregering og ulike typer analytiske teknikker.

Hovedkomponenter i analyse-laget er typisk:

Datamodellering: Datamodellering innebærer å strukturere data på en måte som gjør det enkelt å forstå og analysere. Dette inkluderer å bygge dimensjonsmodeller, stjerneskjemaer og snøfnuggsmodeller som gjør det lettere å utføre analyser og rapportering. Aggregering samler og oppsummerer data for å gi en oversikt over større datamengder. Dette kan inkludere å beregne gjennomsnitt, sum, antall, maksimum og minimum verdier.

Metrics-lag: Metrics-laget fungerer som et semantisk lag der forretningslogikk og definisjoner er standardisert. Dette laget sikrer at alle brukere i organisasjonen bruker de samme definisjonene for nøkkeltall og måleparametere, noe som fremmer konsistens og nøyaktighet i rapportering og analyse. Produktlønnsomheten for en vare skal for eksempel være lik både når den vises i Power BI, i et dashboard i en webportal og når den hentes inn som et måltal i en data science notebook. En implementering av et felles begrepsapprat i dette laget kalles også et semantisk lag.

Maskinlæring og AI: Maskinlæring og kunstig intelligens (AI) benyttes for å oppdage mønstre i data, automatisere beslutningsprosesser og bygge prediktive modeller. Dette inkluderer bruk av teknikker som nevrale nettverk, beslutningstrær og klusteranalyse.

Dataforberedelse og feature engineering er kritiske trinn i maskinlæringsprosessen. Dette innebærer rengjøring, transformasjon og strukturering av data for å gjøre dem klare for modellering. Feature engineering handler om å lage nye variabler (features) fra rådata som kan forbedre modellens ytelse, og kan med fordel lages som et logisk lag over dataene dine.

Modellutvikling og eksperimentering involverer bruk av verktøy og plattformer for å bygge, teste og evaluere maskinlæringsmodeller. Dette inkluderer eksperimentstyring for å spore og sammenligne resultater fra ulike modelltreninger og hyperparameter-tuning.

6. Konsum

Konsumlaget sin rolle er å presentere data tilpasset ulike bruksscenarier og brukergrupper, slik at data kan omsettes til informasjon som igjen benyttes til å skape verdi. Konsumlaget inneholder verktøy som spenner fra enkel presentasjon av standardiserte rapporter til maskinell behandling ved hjelp av avanserte maskinlæringsalgoritmer og kunstig intelligens.

Konsum-kapabiliteter omfatter ofte:

- Fast rapportering og dashboards: Fast rapportering og dashboards gir øyeblikkelig og oppdatert tilgang til data og informasjon, ofte visualisert i grafer, diagrammer eller KPI-indikatorer. Dashboards gir en rask oversikt over nøkkeltall eller trender som hjelper beslutningstakere å forstå forretningsstatusen raskt.

- Selvbetjeningsverktøy for analyse: Selvbetjeningsverktøy gir sluttbrukere muligheten til å hente ut, analysere og visualisere data på egen hånd, uten å ha særlig teknisk kunnskap. Disse verktøyene fremmer datautforskning og analyse på en enkel og intuitiv måte.

- Data Science og AI-verktøy: Data Science og AI-verktøy er avanserte verktøy designet for dataanalyse, statistikk, maskinlæring og kunstig intelligens. De brukes til å bygge, trene og implementere modeller for å forutsi, klassifisere eller erkjenne mønstre i store datamengder.

- App-rammeverk og skreddersydde applikasjoner: App-rammeverk og skreddersydde applikasjoner gir utviklere muligheten til å bygge tilpassede applikasjoner for spesifikke forretningsbehov eller prosesser. Disse applikasjonene kan visualisere data på unike måter og integrere dataanalyse i forretningsprosesser. Eksempler på rammeverk er React, Angular og Django.

- Modell-APIer og inferenstjenester: Modell APIer og inferens tjenester gjør det mulig å integrere maskinlæringsmodeller direkte i applikasjoner og arbeidsflyter. Dette inkluderer RESTful APIer for modellprediksjoner og batch-inferens for store datamengder.

- Automatiserte beslutningssystemer: Automatiserte beslutningssystemer bruker AI og maskinlæringsmodeller for å ta beslutninger uten menneskelig inngripen. Dette inkluderer systemer for å automatisere komplekse beslutningsprosesser i sanntid.

Historisk har verktøyene i konsumlaget vært preget av at de har krevd mennesker med spesialisert kompetanse for å utvikle rapporter som kombinerer god visuell og pedagosisk presentasjonsform med riktige måltall. De siste årene, og spesielt med lanseringene av verktøy som Tableau, Qlik og Power BI, har selvbetjeningskonseptet skutt fart.

Brukervennlighet og selvbetjening er avgjørende for å skalere innsikt fra å være en nisjekompetanse i virksomheten til å bli en naturlig del av alle medarbeidere sine arbeidsprosesser. Som en del av demokratiseringen av data har også konsumlaget i større grad utviklet seg mot å være et område eller en portal for deling av data, deling av analytiske resultater og samarbeid om utvikling av innsikt.

7. Støttefunksjoner og governance

Oversikt over støttefunksjoner og governance

Støtte- og governance-verktøy bidrar til å svare på spørsmål som hvilke data finnes, hvor de kommer fra, hvordan er de behandlet, hvor sensitive er de, og hvem skal ha tilgang? I tillegg er verktøy for å monitorere driftsprosesser, logge hendelser og sikre datakvalitet sentrale for effektiv drift og forvaltning.

I denne delen av dataplattformen kan vi kategorisere verktøyene i følgende grupper:

- Data Governance

- Data Discovery

- Data Observability

- Sikkerhet og tilgangsstyring

- Overvåkning og logging

- CI/CD og kodehåndtering

Data governance

Over tid ser vi en utvikling i retning av at verktøyene som konsumerer data fra dataplattformen har fått stadig større bredde, flere brukere og dekker flere brukermiljøer.

Dette gjør at det blir stadig viktigere å få en felles oversikt over gjenbrukbare definisjoner slik at virksomheten kan etablere et felles begrepsapparat. Det er viktig å maskinelt kunne følge hvilke data som brukes hvor, og av hvem.

Data Governance er en disiplin som innebærer å ha tydelige beslutningsstrukturer og ansvarsfordeling for å guide bruk av data for å skape verdier. Data Governance er viktig for dataplattformen, men er en disiplin som strekker seg helt fra datakildene til de spesifikke bruksscenariene som realiseres utenfor selve dataplattformen.

Typiske funksjoner knyttet til Data Governance i en dataplattform inkluderer:

- Metadatahåndtering: Administrere og dokumentere metadata for bedre dataforståelse og bruk.

- Dokumentasjon i kode: Sikre at kode og dataanalyser er godt dokumentert for transparens og gjenbruk.

- FinOps: Oversikt over kostnader knyttet til databehandling og lagring.

- DataOps: Oversikt over dataflyt, hva som er kjørt og lagret.

- Data Lineage: Sporing av data fra kilde til konsum for å forstå dataenes opprinnelse og transformasjoner.

- Sikkerhet og compliance for AI: Inkluderer retningslinjer og prosedyrer for å sikre at AI-modeller opererer innenfor juridiske og etiske rammer.

Data discovery

Data Discovery beskriver prosesser og verktøy som benyttes for å oppdage, scanne og beskrive datasettene som finnes i virksomheten. Data Discovery kombinerer søkekapabiliteter, automatisk scanning, katalogisering og modellering med menneskers domenekunnskaper for å formidle kunnskap som er nødvendig for å skalere opp bruken av analytisk innsikt. Dette gjør det mulig for brukerne å finne relevante data raskt og effektivt, noe som igjen støtter datadrevne beslutninger og innsikter.

Typiske funksjoner knyttet til Data Discovery i en dataplattform inkluderer:

- Datakatalogisering: Opprette en søkbar katalog over tilgjengelige data for enkel tilgang og oversikt.

- Dataprofilering: Analysere datasett for å forstå deres struktur, innhold og kvalitet, og dermed identifisere relevante data for spesifikke behov.

- Søk og spørringer: Tilrettelegge for søkefunksjoner og spørringer slik at brukere raskt kan finne og hente ut data.

Data observability

Data observability er et samlebegrep for evnen til å observere og håndtere datakvalitet på tvers av applikasjoner i virksomheten. Observability som begrep kommer fra DevOps-tankegangen innenfor programvareutvikling, der automatisert overvåkning av data brukes for å evaluere datakvalitet.

Data observability inkluderer både verktøy for monitorering og datakvalitetshåndtering, samt mer avansert funksjonalitet som maskinlæringsalgoritmer for identifisering av unormale verdier, endringer i datamønstre og skjemaendringer. Det er vanlig å dele data observability inn i fem grunnpillarer:

- Volum: Sikrer at innholdet er komplett. For eksempel, hvis det normalt mottas 2-3 millioner rader per time, kan mottak av kun 100 000 rader indikere problemer

- Ferskhet: Overvåker om dataene er oppdaterte og identifiserer eventuelle hull eller brudd i kontinuiteten.

- Fordeling: Kontrollerer om verdiene er innenfor forventet variasjonsbredde.

- Struktur/skjema: Sporer endringer i datasettets formelle struktur, inkludert hva som har endret seg og når endringene skjedde.

- Lineage: Kartlegger dataenes opprinnelse og prosesseringstrinn på veien gjennom systemet.

Disse grunnpillarene er nesten sammenfallende med det vi innenfor datakvalitet omtaler som datakvalitetsdimensjonene, og viser hvor sentralt datakvalitet er for data observability.

Sikkerhet og tilgangsstyring

Sikkerhet og tilgangsstyring består av teknologi og, kanskje viktigst, gode prosesser og rutiner for å beskytte data mot uautorisert tilgang, lekkasjer, brudd på lovkrav og brudd på etiske retningslinjer gjennom hele livssyklusen.

Håndtering av sikkerhet kompliseres ofte av mange miljøer. En moderne dataplattform benytter seg gjerne av en samlet sikkerhetsplattform fremfor flere ulike løsninger. En slik plattform gjør det enklere å standardisere sikkerhet på tvers av skyplattformer og reduserer manuelle prosesser.

En moderne sikkerhetsplattform kan sentralisere sikkerhetsregler og anvende disse i en eller flere skymiljøer, som Azure Data Lake, Google BigQuery eller Snowflake, uten at reglene må skrives om og tilpasses hver dataplattform.

Nøkkelfunksjoner i en sikkerhetsplattform er:

- Automatisert oppdagelse av sensitive data: Verktøyet scanner datasett og klassifiserer eller foreslår klassifisering av sensitive data som fødselsnummer, betalingsinformasjon, etc.

- Sporing av bruk og tilgang til data: Overvåker hvem som bruker data og hvordan, slik at unormal aktivitet kan oppdages.

- Automatisert håndheving av policies: Synkronisering av metadata med datakataloger eller systemer for identitetsstyring, noe som muliggjør automatisert tilgangsstyring.

- Standardisering av sikkerhetsprotokoller: Appliserer sentraliserte sikkerhetsregler på tvers av ulike skymiljøer, noe som sikrer konsistens og reduserer risiko.

- Reduksjon av manuelle prosesser: Automatiserer sikkerhetsoppgaver for å minimere menneskelige feil og øke effektiviteten.

Overvåkning og logging

Overvåkning og logging er kritiske komponenter i en dataplattform for å sikre stabil drift, identifisere problemer raskt og opprettholde høy ytelse. Disse funksjonene gir innsikt i systemets tilstand og bidrar til å oppdage avvik og feilsituasjoner i sanntid. Typisk vil man begynne med basic overvåkning og logging, og så bygge denne ut etter hvert som det dukker opp risiko-områder.

Typiske funksjoner innen overvåkning og logging inkluderer:

- Sanntidsovervåkning: Kontinuerlig overvåking av systemets ytelse og tilstand for å sikre optimal drift og rask identifisering av problemer.

- Hendelseslogging: Detaljert logging av alle systemhendelser, inkludert feil, advarsler og informasjon om databehandlingsprosesser.

- Varsling og alarmer: Automatisert varsling ved avvik eller problemer for å muliggjøre rask respons og problemløsning. Dette kan f.eks være noe så enkelt som å automatisere utsendelse av mailer, SMSer eller Teams-meldinger.

- Analyse av loggdata: Bruk av logganalyseverktøy for å identifisere mønstre, trender og rotårsaker til problemer.

Kontinuerlig læring og ML-modelloppdatering

Kontinuerlig læring og modelloppdatering er kritiske prosesser for å sikre at maskinlæringsmodeller forblir nøyaktige og relevante over tid, spesielt i dynamiske miljøer der data og forretningsforhold stadig endres. Denne prosessen inkluderer flere nøkkelaspekter:

- Modellovervåking: Kontinuerlig overvåking av modellens ytelse i produksjon innebærer å spore nøkkelmetrikker som nøyaktighet, presisjon, tilbakekalling og F1-score, samt å identifisere avvik eller degradering i ytelsen. Ved å overvåke modellen i sanntid kan man raskt oppdage og håndtere problemer.

- Automatiserte treningspipelines: Automatisering av modelltrening og oppdatering er avgjørende for å opprettholde effektiviteten og skalerbarheten i modelladministrasjonen. Dette inkluderer verktøy og plattformer som automatiserer hele treningsprosessen, fra dataforberedelse til modelltrening, validering og distribusjon.

- Modellversjonering: Modellversjonering innebærer å dokumentere hver versjon av modellen, inkludert treningsdata, hyperparametere, algoritmer og ytelsesmetrikker, for å holde oversikt over ulike versjoner og deres ytelse.

- Automatisert retrening: Regelmessig retrening av modeller med nye data er nødvendig for å tilpasse seg endringer i data og miljø. Automatiserte retreningsprosesser bruker nye data til å oppdatere modellene, noe som sikrer at de forblir relevante og nøyaktige.

- Datadrevet feedback loop: En kontinuerlig feedback loop fra produksjonsmiljøet tilbake til treningsmiljøet er essensiell for kontinuerlig læring. Dette innebærer å samle inn og analysere nye data, brukerinteraksjoner og andre relevante signaler for å forbedre modellens ytelse over tid.

- Compliance og etikk: Kontinuerlig læring må også ta hensyn til juridiske og etiske aspekter. Dette innebærer å sikre at modellene opererer innenfor juridiske rammer, opprettholder personvern og unngår skjevheter som kan føre til urettferdige eller diskriminerende resultater. Regelmessig revisjon og justering av modellene sikrer samsvar med gjeldende regelverk og etiske retningslinjer.

CI/CD og kodehåndtering

Kontinuerlig integrasjon (CI) og kontinuerlig distribusjon (CD) er viktig praksis hentet til data-domenet fra moderne programvareutvikling. Disse praksisene sikrer at koden er i en konstant tilstand av integrasjon, testing og distribusjon, noe som resulterer i raskere utviklingssykluser og høyere kvalitet.

Typiske funksjoner innen CI/CD og kodehåndtering inkluderer:

- Versjonskontroll: Bruk av verktøy som Git for å administrere og versjonere kodebaser, noe som muliggjør samarbeid og sporbarhet.

- Automatisert bygging: Automatiserte byggeprosesser som kompilering og testing av kode for å sikre at den fungerer som forventet.

- Automatisert testing: Integrasjon av testskript som kjører automatisk ved kodeendring for å validere funksjonalitet og identifisere feil tidlig.

- Kontinuerlig distribusjon: Automatisering av distribusjonsprosessen slik at endringer raskt kan settes i produksjon etter godkjenning.

- Miljøhåndtering: Administrasjon av forskjellige utviklings-, test- og produksjonsmiljøer for å sikre konsistens og stabilitet på tvers av distribusjoner.

Eksempler på typiske arkitekturmønstre

Data Lakehouse med batch-integrasjon

Data Lakehouse kombinerer egenskapene til datalake og datavarehus, og bruker batch-integrasjon for å hente, transformere og laste data.

- Datakilder: Data hentes fra ulike kilder, som transaksjonssystemer og logger

- Batch-prosessering: Data lastes inn i data lake i batcher på bestemte tidspunkter.

- Data Lakehouse: Kombinerer rådata fra data lake med strukturerte data organisert videre i datavarehus-lag.

- Analyse og rapportering: Brukere utfører spørringer og analyser på dataene for innsikt og beslutningsstøtte.

Analytiske og operasjonelle data i hybrid

Dette arkitekturmønsteret integrerer både analytiske og operasjonelle data i et hybridmiljø for å støtte sanntidsbeslutninger og dypere analyser.

- Operasjonelle datakilder: Sanntidsdata fra operasjonelle systemer som CRM og sensorer, i kombinasjon med data hentet i batcher.

- Hybrid datalagring: Data lagres både i sanntidsdatabaser og i databaser for historisk analyse.

- Dypanalyse: Batchprosesser for historiske trender og prediktiv analyse. ofte i kombinasjon med sanntidsdashboards og enkle regler for varsling av avvik.

Maskinlæring i utvikling og produksjon

Dette mønsteret fokuserer på maskinlæring fra eksperimentering til produksjon, med separate miljøer for utvikling og produksjon.

- Datainnsamling: Data samles fra ulike kilder og lagres som rådata.

- Dataforberedelse: Data renses og transformeres for bruk i maskinlæring.

- Feature store: Lagrer og gjenbruker features på tvers av ulike prosjekter, gjerne som et logisk lag på toppen av rådataene.

- Modellutvikling: Data scientists eksperimenterer og trener modeller i et utviklingsmiljø.

- Modelldeployering: Godkjente modeller distribueres til produksjonsmiljøet.

- Modellovervåking: Kontinuerlig overvåking og oppdatering av modeller for å sikre nøyaktighet.

Veien videre

Gjennom denne veiledningen har vi dekket de viktigste komponentene i en dataplattform, inkludert datakilder, dataflytting og dataintegrasjon, lagring, spørring og prosessering, analyse, konsum, og støttefunksjoner og governance.

Husk at enn dataplattform er ikke statisk; den utvikler seg kontinuerlig for å møte endrede behov og teknologiske fremskritt. Implementering av avanserte funksjoner som orkestrering, data observability og automatiserte modelloppdateringer er eksempler på funksjonaliteter som mange ikke har innført fullt ut.